使用 Chinda LLM 4B 和 n8n - 完整工作流程自动化指南

🎯 简介

Chinda LLM 4B 是由 iApp Technology 团队开发的开源泰语语言模型,能够使用最新的 Qwen3-4B 架构以高准确性进行泰语思考和响应。

n8n 是一个强大的��工作流程自动化工具,允许您在不进行编码的情况下连接不同的服务并自动化任务。通过将 Chinda LLM 4B 与 n8n 集成,您可以创建复杂的 AI 驱动型工作流程,自动处理泰语数据。

🚀 步骤 1:安装 n8n

方法 1:使用 npm(推荐用于开发)

安装 Node.js(如果尚未安装)

从 https://nodejs.org/ 下载并安装 Node.js

全局安装 n8n:

npm install n8n -g

启动 n8n:

n8n start

方法 2:使用 Docker(推荐用于生产)

拉取并运行 n8n Docker 容器:

docker run -it --rm \

--name n8n \

-p 5678:5678 \

-v ~/.n8n:/home/node/.n8n \

n8nio/n8n

方法 3:使用 npx(无需安装)

npx n8n

验证安装

启动 n8n 后,打开浏览器并访问:

http://localhost:5678

您应该会看到 n8n 界面和欢迎屏幕。

🔍 步骤 2:设置 Chinda LLM 4B

选项 A:使用 Ollama 后端(推荐)

安装 Ollama:

curl -fsSL https://ollama.com/install.sh | sh

下载 Chinda LLM 4B:

ollama pull iapp/chinda-qwen3-4b

启动 Ollama API 服务器:

ollama serve

API 将在 http://localhost:11434 上可用

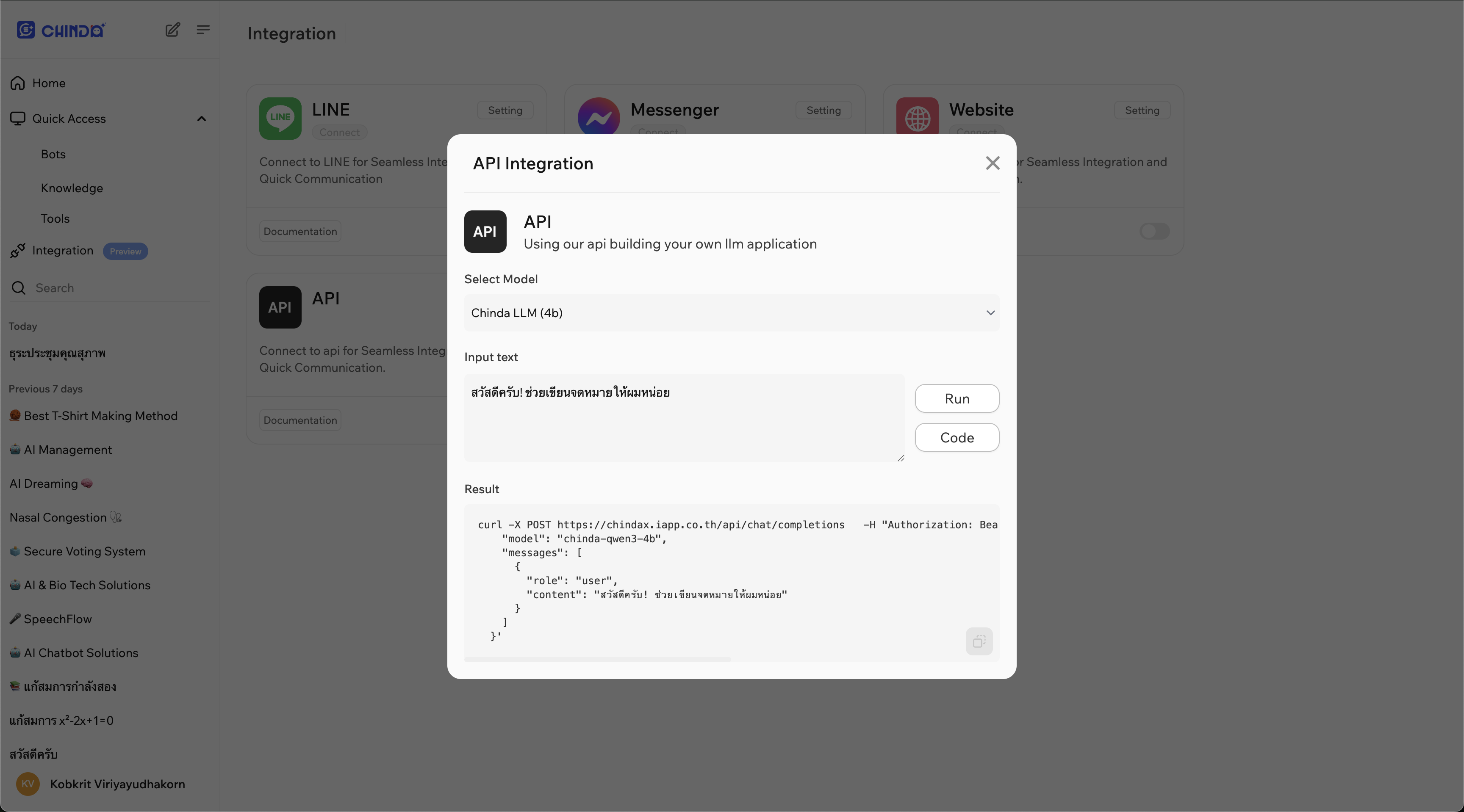

选项 B:使用直接 API 端点

- 在浏览器中打开 ChindaX 平台(https://chindax.iapp.co.th)

- 在 ChindaX 网站上注册 / 登录。

- 转到左侧的集成菜单。

- 点击API集成右上角的设置按钮。

- 从代码块中复制URL和Bearer Token。

⚙️ 步骤 3:创建您的第一个工作流程

基本工作流程设置

- 在浏览器中打开 n8n(

http://localhost:5678) - **点击“新建工作流程”**以创建新的自动化

- 添加节点以创建您的 AI 工作流程

示例 1:简单的文本处理工作流程

步骤 1:添加手动触发器

- 点击“+”按钮添加节点

- 搜索“手动触发器”并选择它

- 点击“执行节点”进行测试

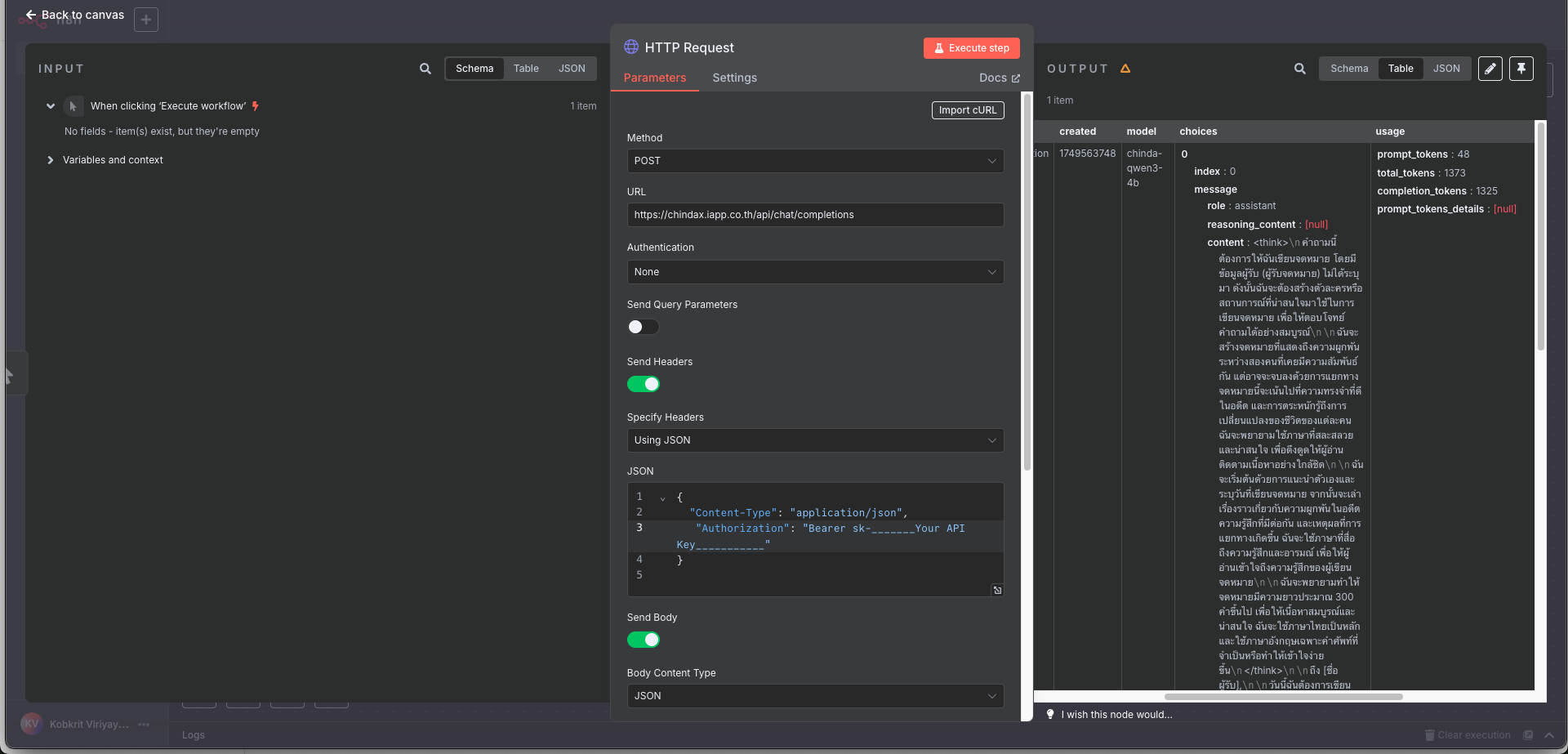

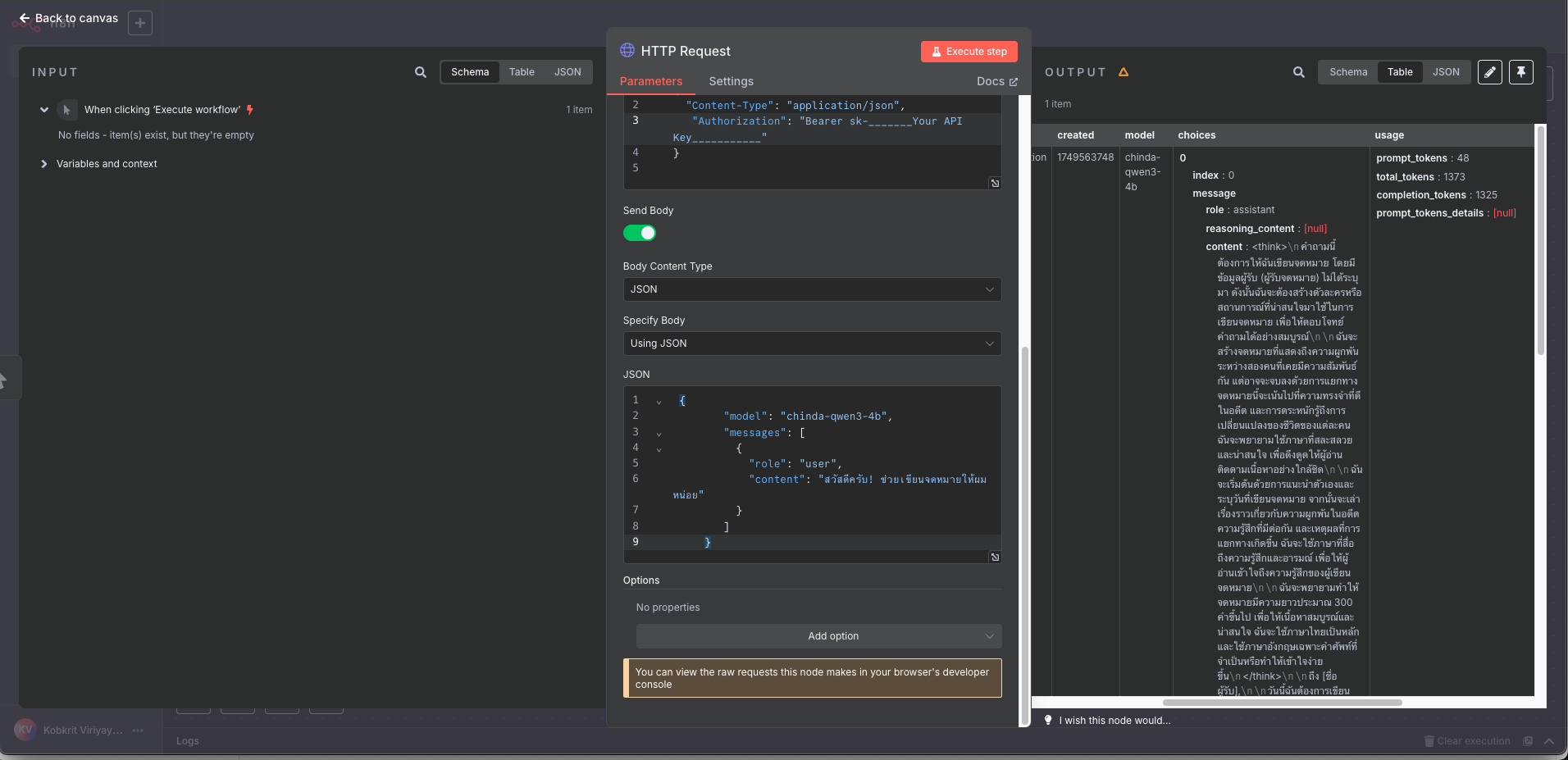

步骤 2:添加 HTTP 请求节点

- 添加另一个节点并搜索“HTTP 请求”

- 配置 HTTP 请求节点:

- 方法:POST

- URL:

http://localhost:11434/api/generate或https://chindax.iapp.co.th/api/chat/completions(来自 ChindaX) - Headers:如果您从 ChindaX 获取 API,请勿忘记添加“Authorization”键。

{

"Content-Type": "application/json",

"Authorization": "Bearer sk-********************",

} - Body:(用于 Ollama)

{

"model": "iapp/chinda-qwen3-4b",

"prompt": "สวัสดีครับ ช่วยอธิบายเกี่ยวกับปัญญาประดิษฐ์ให้ฟังหน่อย",

"stream": false

} - Body:(用于 ChindaX)

{

"model": "chinda-qwen3-4b",

"messages": [

{

"role": "user",

"content": "สวัสดีครับ! ช่วยเขียนจดหมายให้ผมหน่อย"

}

]

}

步骤 3:添加 Set 节点(可选)

- 添加“Set”节点来格式化响应

- 配置以提取 AI 响应:

- 仅保留设置:启用

- 要设置的值:

- 名称:

ai_response - 值:

{{ $json.response }}

- 名称:

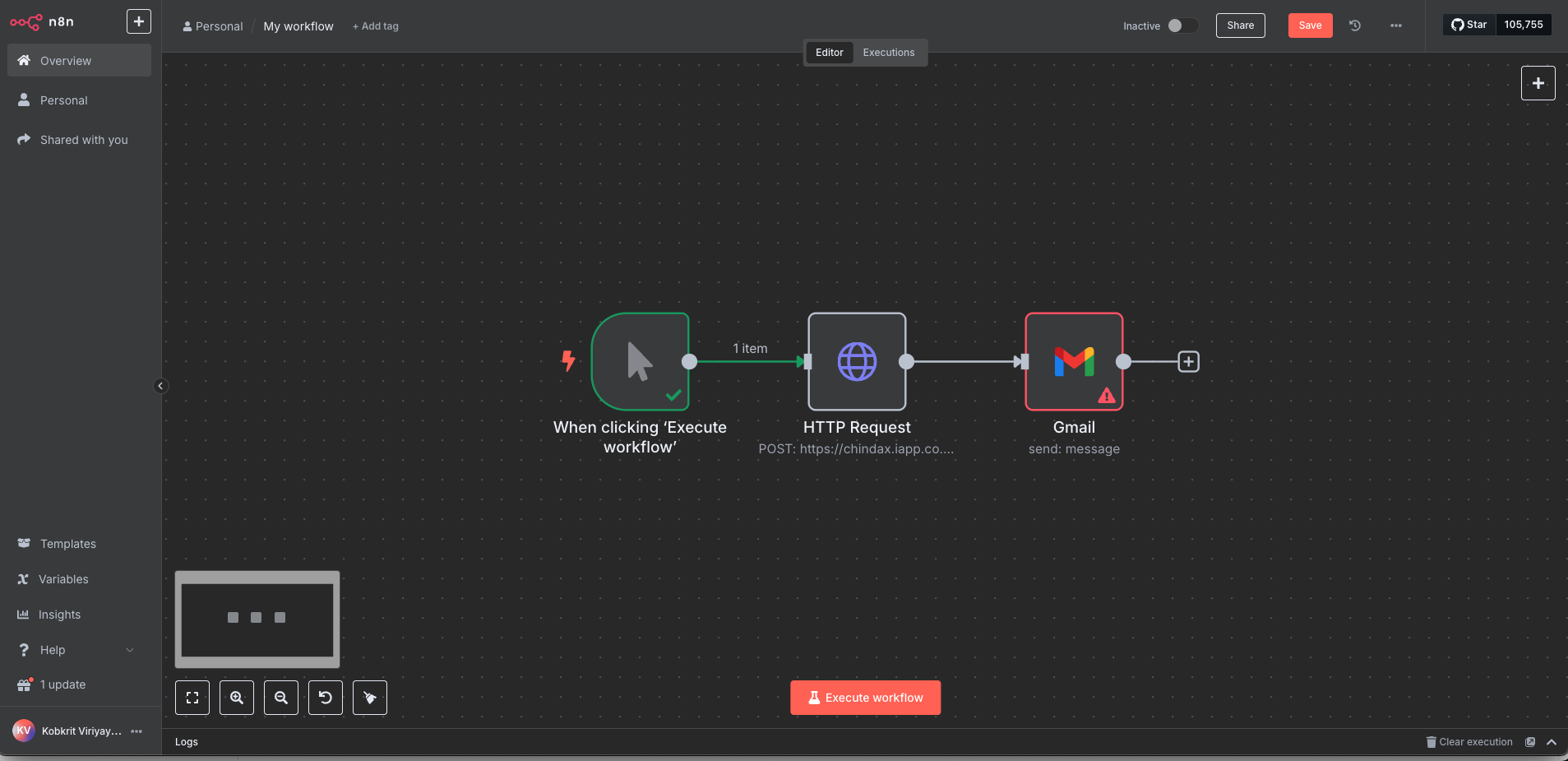

示例 2:电子邮件处理工作流程

此工作流程可自动处理泰语电子邮件并生成回复。

工作流程结构:

电子邮件触发器 → 提取电子邮件内容 → Chinda LLM 处理 → 发送回复

步骤 1:添加电子邮件触发器

- 添加“电子邮件触发器 (IMAP)”节点

- 配置您的电子邮件设置:

- 主机:您的电子邮件提供商的 IMAP 服务器

- 端口:通常是 SSL 的 993

- 用户名:您的电子邮件地址

- 密码:您的电子邮件密码

- SSL/TLS:启用

步骤 2:使用 Chinda LLM 进行处理

- 添加“HTTP 请求”节点

- 配置 Chinda LLM:

{

"model": "iapp/chinda-qwen3-4b",

"prompt": "ช่วยตอบอีเมลนี้อย่างสุภาพและเป็นมิตร: {{ $json.text }}",

"stream": false

}

步骤 3:发送回复电子邮件

- 添加“发送电子邮件”节点

- 配置回复设置:

- 收件人:

{{ $json.from.value[0].address }} - 主题:

Re: {{ $json.subject }} - 文本:

{{ $json.response }}

- 收件人:

🌐 步骤 4:高级工作流程

工作流程 1:文档翻译服务

组件:

- Webhook 触发器:通过 HTTP 接收文档

- 提取文本:�处理不同的文件格式

- Chinda LLM:翻译泰语↔英语

- 返回响应:发送翻译内容

设置:

-

添加 Webhook 节点:

- 设置 webhook 路径:

/translate - 方法:POST

- 设置 webhook 路径:

-

添加 Switch 节点(用于文件类型检测):

- 条件 1:PDF 文件

- 条件 2:文本文件

- 条件 3:Word 文档

-

添加 HTTP 请求以连接 Chinda LLM:

{

"model": "iapp/chinda-qwen3-4b",

"prompt": "กรุณาแปลข้อความนี้จากภาษาไทยเป็นภาษาอังกฤษ: {{ $json.text }}",

"stream": false

}

工作流程 2:客户支持聊天机器人

组件:

- 聊天触发器:连接到消息平台

- 上下文管理:维护对话历史记录

- Chinda LLM:生成响应

- 响应格式化:为不同平台格式化

设置:

-

添加 Telegram 触发器(或您首选的平台)

-

添加 Function 节点以进行上下文管理:

// 存储对话上下文

const userId = $input.first().json.message.from.id;

const message = $input.first().json.message.text;

// 检索之前的上下文(实现您的存储逻辑)

const context = await getContext(userId);

return {

userId,

message,

context: context || [],

fullPrompt: `บริบทการสนทนา: ${context.join('\n')}\nคำถามใหม่: ${message}\nตอบ:`

}; -

添加 Chinda LLM 处理

-

添加响应节点返回聊天平台

工作流程 3:内容生成管道

用于博客文章和文章:

- 计划触发器:每天/每周运行

- RSS Feed 阅读器:获取主题创意

- Chinda LLM:生成泰语内容

- 内容格式化:添加 HTML/Markdown

- CMS 发布:自动发布到 WordPress/Ghost

💬 步骤 5:使用 Chinda LLM 节点(自定义集成)

创建自定义 Chinda LLM 节点

如果您经常使用 Chinda LLM,可以创建一个可重用的自定义节点:

步骤 1:创建节点模板

{

"name": "Chinda LLM",

"icon": "🤖",

"group": ["AI"],

"description": "Process text with Chinda LLM 4B",

"properties": [

{

"displayName": "Prompt",

"name": "prompt",

"type": "string",

"required": true,

"default": "",

"description": "Text prompt in Thai"

},

{

"displayName": "Temperature",

"name": "temperature",

"type": "number",

"default": 0.7,

"description": "Controls randomness (0-1)"

}

]

}

使用 Code 节点进行高级处理

添加“Code”节点以进行复杂的泰语文本处理:

// 使用 Chinda LLM 处理泰语文本

const axios = require('axios');

const prompt = $input.first().json.text;

const response = await axios.post('http://localhost:11434/api/generate', {

model: 'iapp/chinda-qwen3-4b',

prompt: `ประมวลผลข้อความนี้: ${prompt}`,

stream: false,

options: {

temperature: 0.7,

top_p: 0.9

}

});

return {

original: prompt,

processed: response.data.response,

timestamp: new Date().toISOString()

};

🔧 故障排除

常见问题及解决方案

问题:Ollama 连接被拒绝

Error: connect ECONNREFUSED 127.0.0.1:11434

解决方案:确保 Ollama 正在运行:

ollama serve

问题:n8n 工作流程超时

解决方案:在 HTTP 请求节点中增加超时时间:

- 设置超时:30000(30 秒)

- 对于更长的响应,请进一步增加

问题:大型提示的内存问题

解决方案:

- 将大型文本分成小块

- 在工作流程中使用分页

- 先实现文本摘要

问题:泰语文本编码问题

解决方案:确保 UTF-8 编码正确:

// 在 Code 节点中

const text = Buffer.from(inputText, 'utf8').toString('utf8');

性能优化技巧

- 使用批量处理以进行多个请求

- 为频繁使用的提示实现缓存

- 根据提示的复杂性设置适当的超时时间

- 监控 Ollama 进程的资源使用情况

🎯 工作流程模板和用例

✅ 可立即使用的工作流程模板

1. 文档摘要服务

- 输入:长泰语文档

- 处理:分块 → 摘要每一块 → 组合

- 输出:简洁的泰语摘要

2. 社交媒体自动回复器

- 触发器:新的提及/评论

- 处理:分析情绪 → 生成适当的回复

- 操作:自动发布回复

3. 电子邮件新闻通讯生成器

- 计划:每周触发

- 处理:收集新闻 → 生成泰语内容 → 格式化

- 操作:发送给订阅者列表

4. 客户反馈分析器

- 输入:客户评论/反馈

- 处理:情绪分析 → 分类 → 回复

- 输出:洞察仪表板

5. 语言学习助手

- 输入:学生提供的英语文本

- 处理:翻译 → 解释语法 → 提供示例

- 输出:全面的学习材料

🔄 集成示例

与流行服务集成:

Google Sheets:

- 读取数据 → 使用 Chinda LLM 处理 → 写入结果

Slack/Discord:

- 监控频道 → 回答问题 → 提供摘要

WordPress:

- 生成内容 → 自动发布 → SEO 优化

Shopify:

- 产品描述 → 客户支持 → 订单处理

🚀 高级配置

环境变量设置

为 n8n 创建 .env 文件:

# n8n 配置

N8N_BASIC_AUTH_ACTIVE=true

N8N_BASIC_AUTH_USER=admin

N8N_BASIC_AUTH_PASSWORD=yourpassword

# Ollama 配置

OLLAMA_HOST=http://localhost:11434

CHINDA_MODEL=iapp/chinda-qwen3-4b

# Webhook 配置

WEBHOOK_URL=http://localhost:5678/webhook

Docker Compose 设置

version: '3.8'

services:

n8n:

image: n8nio/n8n

ports:

- "5678:5678"

environment:

- N8N_BASIC_AUTH_ACTIVE=true

- N8N_BASIC_AUTH_USER=admin

- N8N_BASIC_AUTH_PASSWORD=yourpassword

volumes:

- ~/.n8n:/home/node/.n8n

depends_on:

- ollama

ollama:

image: ollama/ollama

ports:

- "11434:11434"

volumes:

- ollama:/root/.ollama

command: serve

volumes:

ollama:

使用以下命令运行:

docker-compose up -d

📊 监控和分析

工作流程性能跟踪

添加监控节点以跟踪:

- Chinda LLM 的响应时间

- 工作流程的成功/失败率

- 每个工作流程的使用统计信息

- 成本跟踪(如果使用付费 API)

示例监控工作流程:

工作流程执行 → 记录性能 → 更新仪表板 → 发送警报

🔮 最佳实践

1. 泰语提示工程

- 使用清晰、有上下文的泰语提示

- 必要时提供示例

- 明确输出格式要求

2. 错误处理

- 始终添加错误处理节点

- 实现重试机制

- 记录错误以进行调试

3. 安全注意事项

- 使用环境变量存储敏感数据

- 实现适当的身份验证

- 在处理之前验证输入

4. 可扩展性

- 设计工作流程以处理各种负载

- 对大批量处理使用队列

- 监控资源消耗

📚 资源和链接

快速参考命令

# 启动 n8n

npm start n8n

# 或

npx n8n

# 或

docker run -p 5678:5678 n8nio/n8n

# 启动 Ollama

ollama serve

# 下载 Chinda LLM

ollama pull iapp/chinda-qwen3-4b

有用链接

- 🌐 n8n 文档:https://docs.n8n.io/

- 🤖 Chinda LLM 演示:https://chindax.iapp.co.th

- 📦 Ollama:https://ollama.com/iapp/chinda-qwen3-4b

- 🏠 iApp 主页:https://iapp.co.th/openmodels/chinda-opensource-llm

- 📄 许可证:Apache 2.0(允许商业和个人使用)

社区和支持

- n8n 社区:https://community.n8n.io/

- iApp 支持:https://iapp.co.th/contact

- GitHub 问题:https://github.com/n8n-io/n8n/issues

🎉 总结

将 Chinda LLM 4B 与 n8n 结合使用,可以创建强大的自动化工作流程,能够大规模处理泰语内容。无论您是构建客户支持系统、内容生成管道还是数据处理工作流程,这种组合都提供了:

- 可视化工作流程轻松创建 - 无需编码

- 强大的泰语处理能力 - 原生泰语 AI 功能

- 灵活的集成 - 连接数百种服务

- 可扩展的架构 - 处理从简单到复杂的各种工作流程

- 经济高效 - 在本地运行,无 API 费用

立即开始使用 n8n 和 Chinda LLM 4B 构建您的泰语 AI 自动化工作流程!

由 iApp Technology Team ❤️ 构建 - 赋能泰语 AI 自动化