使用 Ollama 运行 Chinda LLM 4B - 完整用户指南

🎯 简介

Chinda LLM 4B 是由 艾艾普科技 团队开发的开源泰语语言模型,它使用最新的 Qwen3-4B 架构,能够以高准确度进行思考并用泰语进行回应。

Ollama 是一个强大的命令行工具,可让您在最少的设置和最大的性能下,轻松地在本地计算机上运行大型 AI 模型。

🚀 第一步:安装 Ollama

下载和安装 Ollama

macOS 和 Linux:

curl -fsSL https://ollama.com/install.sh | sh

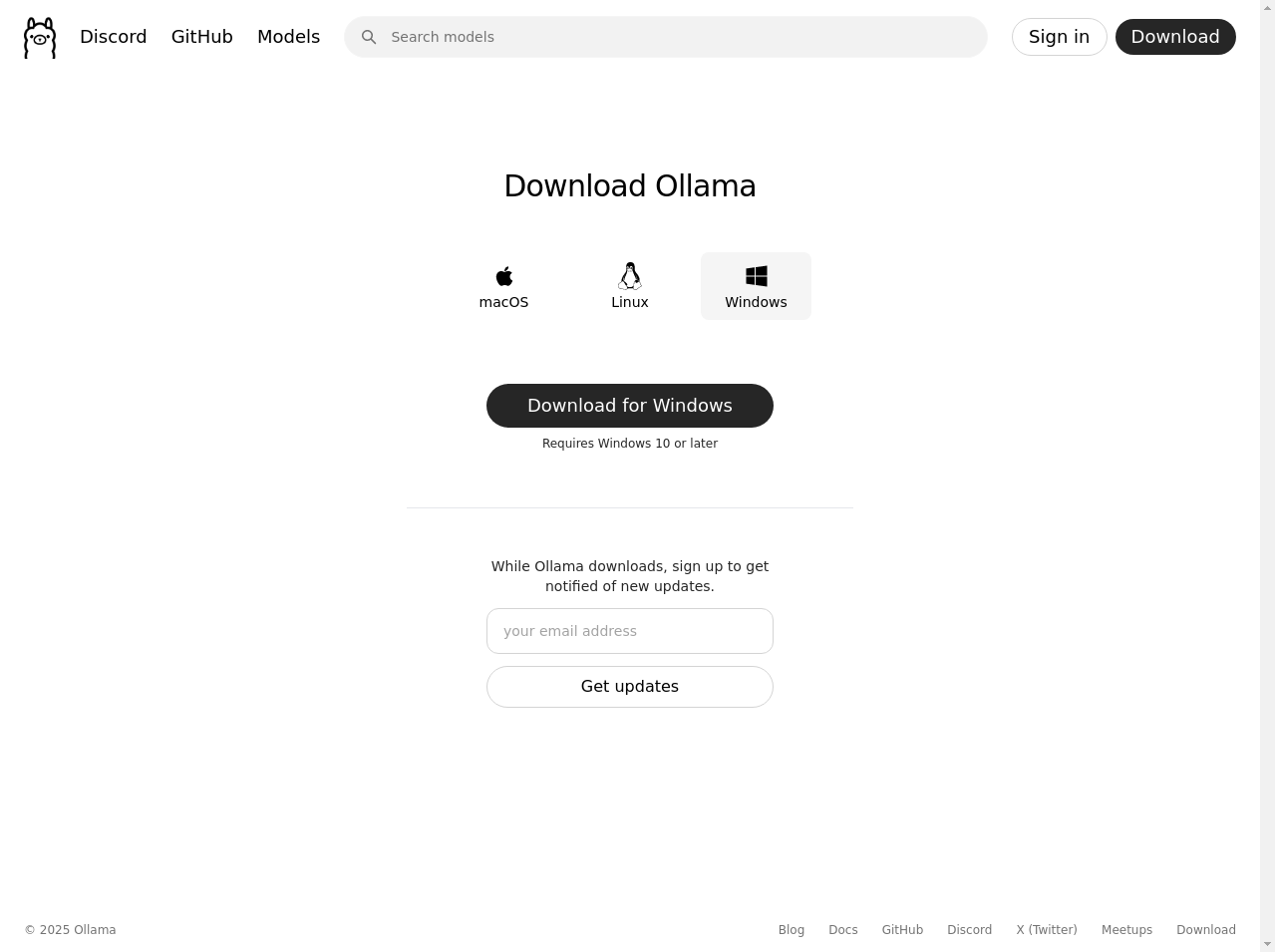

Windows:

- 前往 https://ollama.com/download

- 下载 Windows �安装程序

- 运行安装程序并按照安装向导进行操作

验证安装

安装完成后,打开您的终端或命令提示符并运行:

ollama --version

如果安装成功,您应该会看到 Ollama 的版本信息。

$ ollama --version

ollama version is 0.9.0

🔍 第二步:下载 Chinda LLM 4B 模型

下载模型

安装 Ollama 后,您可以使用一个简单的命令下载 Chinda LLM 4B:

ollama pull iapp/chinda-qwen3-4b

该模型大小约为 2.5GB,根据您的网速,下载需要一些时间。您会看到一个显示下载状态的进度条。

$ ollama pull iapp/chinda-qwen3-4b

pulling manifest

pulling f2c299c8384c: 100% ▕██████████████████▏ 2.5 GB

pulling 62fbfd9ed093: 100% ▕██████████████████▏ 182 B

pulling 70a7c2ca54f5: 100% ▕██████████████████▏ 159 B

pulling c79654219fbe: 100% ▕██████████████████▏ 74 B

pulling e8fb2837968f: 100% ▕██████████████████▏ 487 B

verifying sha256 digest

writing manifest

success

验证模型下载

要检查模型是否已成功下载:

ollama list

您应该会在可用模型列表中看到 chinda-qwen3-4b:latest。

$ ollama list

NAME ID SIZE MODIFIED

iapp/chinda-qwen3-4b:latest f66773e50693 2.5 GB 35 seconds ago

⚙️ 第三步:基本用法

开始与 Chinda LLM 聊天

要启动与 Chinda LLM 4B 的交互式聊天会话:

ollama run iapp/chinda-qwen3-4b

这将启动一个交互式聊天会话,您可以在其中用泰语输入问题并立即获得答案。

对话示例

ollama run iapp/chinda-qwen3-4b

>>> สวัสดีครับ ช่วยอธิบายเกี่ยวกับปัญญาประดิษฐ์ให้ฟังหน่อย

# Chinda LLM 将用泰语解释人工智能

>>> /bye # 输入此命令退出聊天

单次提问模式

如果您想在不进入聊天模式的情况下问一个问题:

ollama run iapp/chinda-qwen3-4b "อธิบายเกี่ยวกับปัญญาประดิษฐ์ให้ฟังหน่อย"

🌐 第四步:API 服务器用法

启动 Ollama API 服务器

对于想要将 Chinda LLM 集成到其应用程序中的开发者:

ollama serve

这将在 http://localhost:11434 上启动 Ollama API 服务器。

使用 curl 调用 API

基本 API 调用:

curl http://localhost:11434/api/generate -d '{

"model": "iapp/chinda-qwen3-4b",

"prompt": "สวัสดีครับ",

"stream": false

}'

聊天 API 调用:

curl http://localhost:11434/api/chat -d '{

"model": "iapp/chinda-qwen3-4b",

"messages": [

{

"role": "user",

"content": "อธิบายเกี่ยวกับปัญญาประดิษฐ์ให้ฟังหน่อย"

}

]

}'

使用 Python

import requests

import json

def chat_with_chinda(message):

url = "http://localhost:11434/api/generate"

data = {

"model": "iapp/chinda-qwen3-4b",

"prompt": message,

"stream": False

}

response = requests.post(url, json=data)

return response.json()["response"]

# 示例用法

response = chat_with_chinda("สวัสดีครับ")

print(response)

💬 第五步:高级用法

设置自定义参数

您可以通过设置参数来自定义模型的行为:

ollama run iapp/chinda-qwen3-4b

>>> /set parameter temperature 0.7

>>> /set parameter top_p 0.9

>>> /set parameter top_k 40

模型信息

要查看模型的详细信息:

ollama show iapp/chinda-qwen3-4b

使用示例

让我们用不同类型的问题进行测试:

数学问题:

ollama run iapp/chinda-qwen3-4b "ช่วยแก้สมการ 2x + 5 = 15 ให้หน่อย"

文档写作:

ollama run iapp/chinda-qwen3-4b "ช่วยเขียนจดหมายขอบคุณลูกค้าให้หน่อย"

编程帮助:

ollama run iapp/chinda-qwen3-4b "เขียนฟังก์ชัน Python สำหรับหาเลขคู่ให้หน่อย"

🔧 故障排除

常见问题及解决方案

问题:找不到模型

Error: pull model manifest: file does not exist

解决方案: 确保您输入的模型名称正确:

ollama pull iapp/chinda-qwen3-4b

问题:Ollama 服务未运行

Error: could not connect to ollama app, is it running?

解决方案: 启动 Ollama 服务:

ollama serve

问题:内存不足

如果您遇到内存问题,可以尝试:

ollama run iapp/chinda-qwen3-4b --low-memory

性能提示

- 关闭不必要的应用程序 以释放内存。

- 使用 SSD 存储 以提高模型加载速度。

- 确保有足够的 RAM (建议:8GB 或更多)。

🎯 适用场景

✅ Chinda LLM 4B 擅长之处

- 文档起草 - 帮助用泰语撰写信件、文章或各种文档。

- RAG (检索增强生成) - 回答来自提供文档的问题。

- 数学问题 - 解决各种级别的数学问题。

- 编程 - 帮助用泰语编写代码并解释功能。

- 语言翻译 - 在泰语和英语之间进行翻译。

- 创意写作 - 生成故事、诗歌或创意内容。

- 教育内容 - 解释概念并提供学习材料。

❌ 需要注意的局限性

不要在没有上下文的情况下询问事实,例如:

- 最新新闻事件

- 具体统计数据

- 关于特定人物或组织的信息

- 实时信息

由于 Chinda LLM 4B 是一个 4B 参数模型,在被问及特定事实时,它可能会生成不正确的信息 (幻觉)。

🚀 模型规格

- 大小: 2.5GB (量化后)

- 上下文窗口: 40K 词元

- 架构: 基于 Qwen3-4B,针对泰语优化

- 性能: 在消费级硬件上快速推理

- 内存要求: 最低 4GB RAM,建议 8GB+

🔮 未来展望

艾艾普科技 团队正在开发一款更大、能更准确回答事实性问题的新模型。预计很快发布。

📚 附加资源

快速参考命令

# 安装 Ollama

curl -fsSL https://ollama.com/install.sh | sh

# 下载 Chinda LLM 4B

ollama pull iapp/chinda-qwen3-4b

# 开始聊天

ollama run iapp/chinda-qwen3-4b

# 列出已安装的模型

ollama list

# 删除模型

ollama rm iapp/chinda-qwen3-4b

# 启动 API 服务器

ollama serve

链接和资源

- 🌐 演示: https://chindax.iapp.co.th (选择 ChindaLLM 4b)

- 📦 模型下载: https://huggingface.co/iapp/chinda-qwen3-4b

- 🐋 Ollama: https://ollama.com/iapp/chinda-qwen3-4b

- 🏠 主页: https://iapp.co.th/openmodels/chinda-opensource-llm

- 📄 许可证: Apache 2.0 (可用于商业和个人用途)

🎉 总结

对于希望在本地使用泰语 AI 模型并获得最大性能和最少设置的用户来说,Ollama 上的 Chinda LLM 4B 是一个绝佳的选择。命令行界面为普通用户和开发人员提供了强大的功能。

使用 Ollama 的主要优点:

- 高性能,推理优化

- 易于安装,只需简单命令

- API 支持,可集成到应用程序中

- 下载后无需互联网

- 注重隐私 - 所有处理都在本地进行

立即开始使用 Chinda LLM 4B,体验在您的本地计算机上运行的泰语 AI 的强大功能!

Built with ❤️ by iApp Technology Team - For Thai AI Development