使用 Chinda LLM 4B 和 OpenWebUI - 完整用户指南

🎯 简介

Chinda LLM 4B 是由 iApp Technology 团队开发的开源泰语语言模型,它能够使用最新的 Qwen3-4B 架构以高精度进行泰语思考和响应。

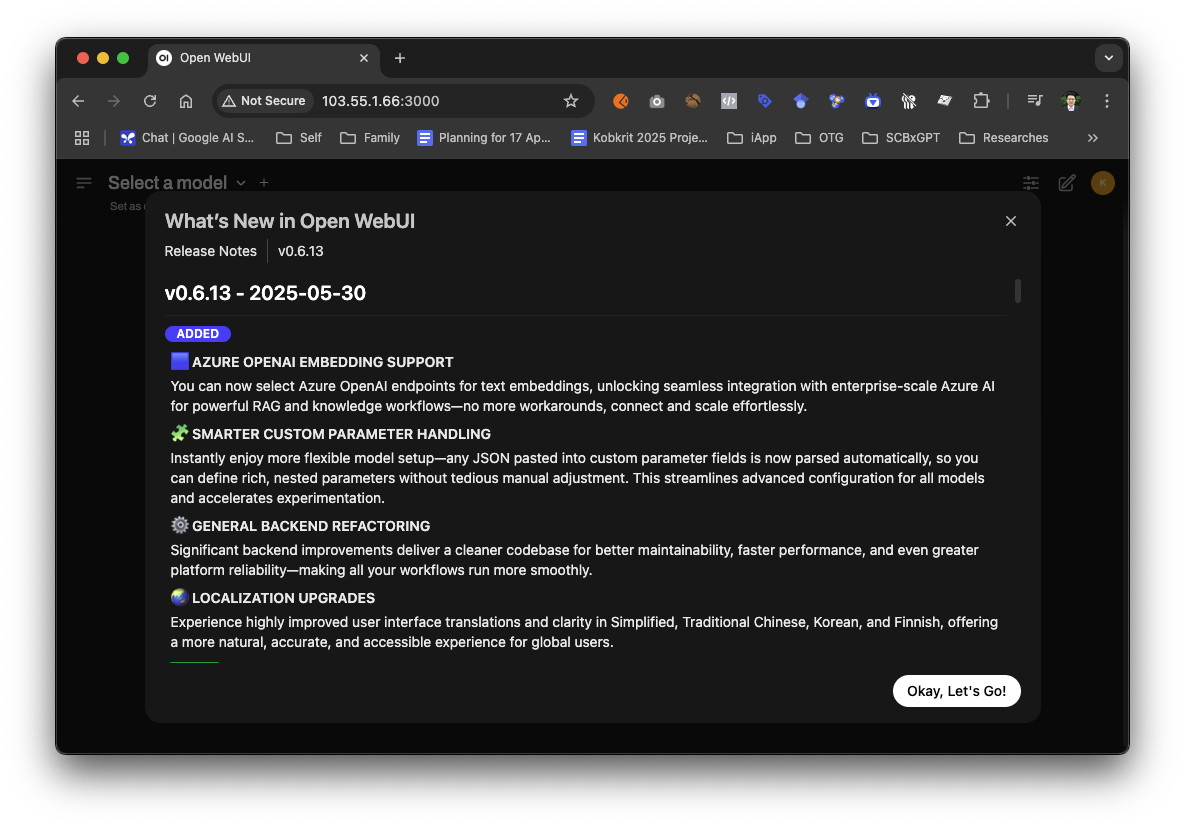

OpenWebUI 是一个美观、用��户友好的 Ollama 的 Web 界面,为本地 AI 模型提供类似 ChatGPT 的体验。它提供了一个直观的聊天界面,具有对话历史、模型管理和可自定义设置等功能。

OpenWebUI 的最新版本(v0.6.13)包含令人兴奋的新功能,例如 Azure OpenAI 嵌入支持、更智能的自定义参数处理、通用的后端重构以及对多种语言的本地化改进。

🚀 第 1 步:安装 Docker

安装 Docker

如果您没有安装 Docker:

- Windows/Mac: 从 https://www.docker.com/products/docker-desktop 下载

- Linux: 遵循您发行版的 Docker 安装指南

GPU 支持设置(可选但推荐)

对于 NVIDIA GPU:

安装 NVIDIA Container Toolkit 以启用 GPU 加速:

Ubuntu/Debian:

# 添加 NVIDIA 包仓库

distribution=$(. /etc/os-release;echo $ID$VERSION_ID)

curl -s -L https://nvidia.github.io/nvidia-docker/gpgkey | sudo apt-key add -

curl -s -L https://nvidia.github.io/nvidia-docker/$distribution/nvidia-docker.list | sudo tee /etc/apt/sources.list.d/nvidia-docker.list

# 安装 nvidia-container-toolkit

sudo apt-get update && sudo apt-get install -y nvidia-container-toolkit

sudo systemctl restart docker

对于其他 Linux 发行版、macOS 或 Windows: 遵循 NVIDIA Container Toolkit 安装指南

📱 第 2 步:运行集成 Ollama 的 OpenWebUI

方法 1:OpenWebUI 与内置 Ollama (推荐)

此方法在单个容器设置中运行 OpenWebUI 和 Ollama:

对于没有 GPU 的系统:

docker run -d -p 3000:8080 -v ollama:/root/.ollama -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:ollama

对于有 NVIDIA GPU 的系统:

docker run -d -p 3000:8080 --gpus all -v ollama:/root/.ollama -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:ollama

方法 2:使用 Docker Compose (高级)

创建一个 docker-compose.yml 文件:

version: '3.8'

services:

open-webui:

image: ghcr.io/open-webui/open-webui:ollama

container_name: open-webui

ports:

- "3000:8080"

volumes:

- ollama:/root/.ollama

- open-webui:/app/backend/data

restart: always

# 取消注释下面的行以支持 GPU

# deploy:

# resources:

# reservations:

# devices:

# - driver: nvidia

# count: all

# capabilities: [gpu]

volumes:

ollama:

open-webui:

运行:

docker-compose up -d

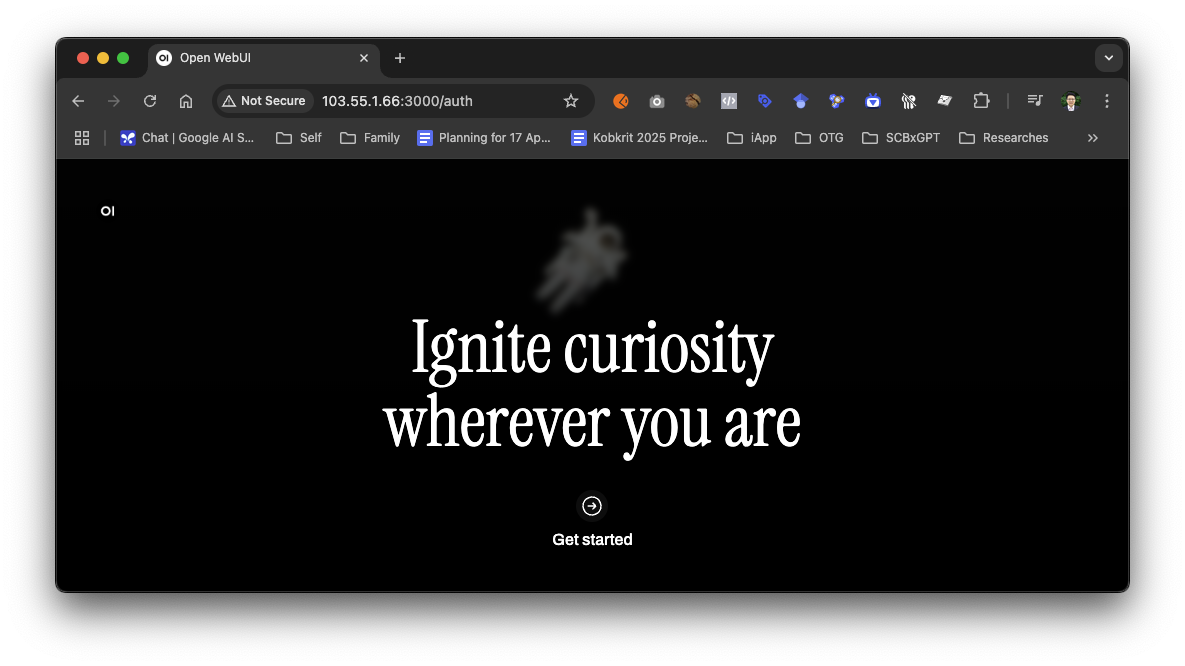

访问 OpenWebUI

- 打开您的网页浏览器

- 前往

http://localhost:3000 - 您应该会看到 OpenWebUI 的欢迎屏幕

🔍 第 3 步:下载 Chinda LLM 4B 模型

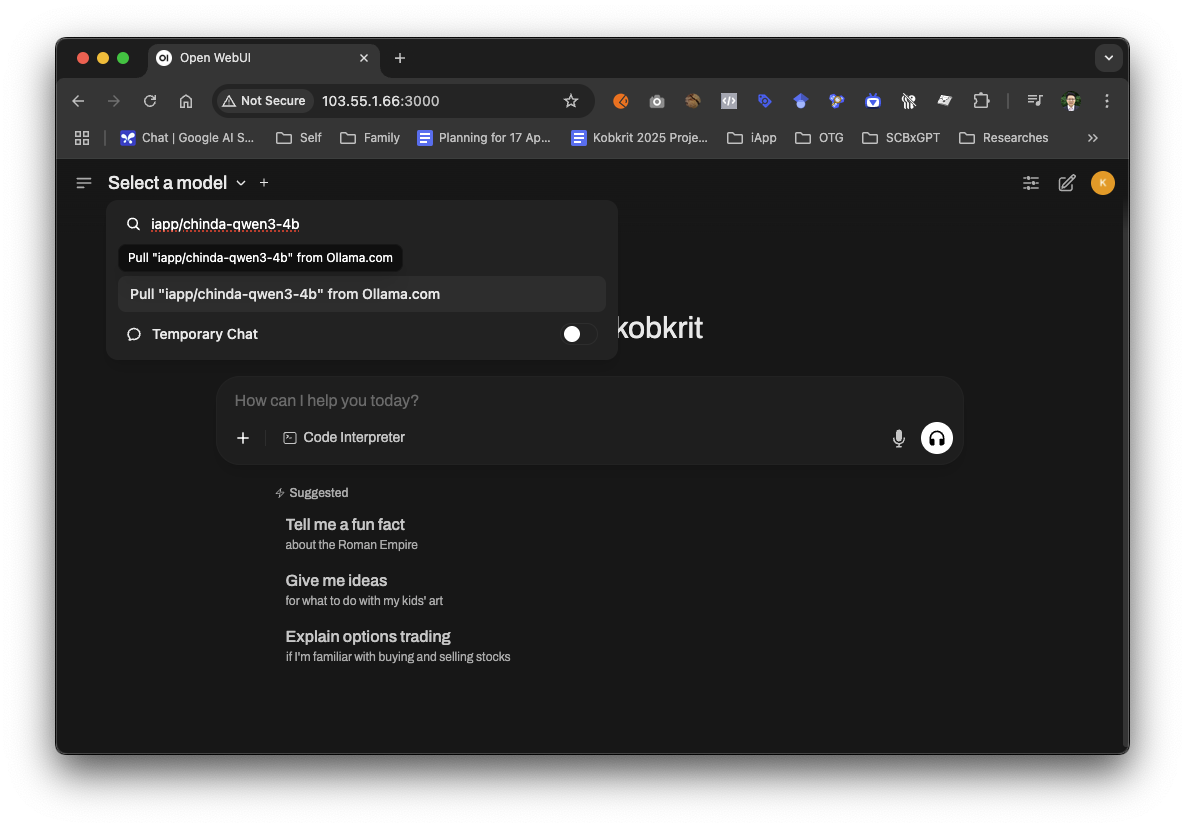

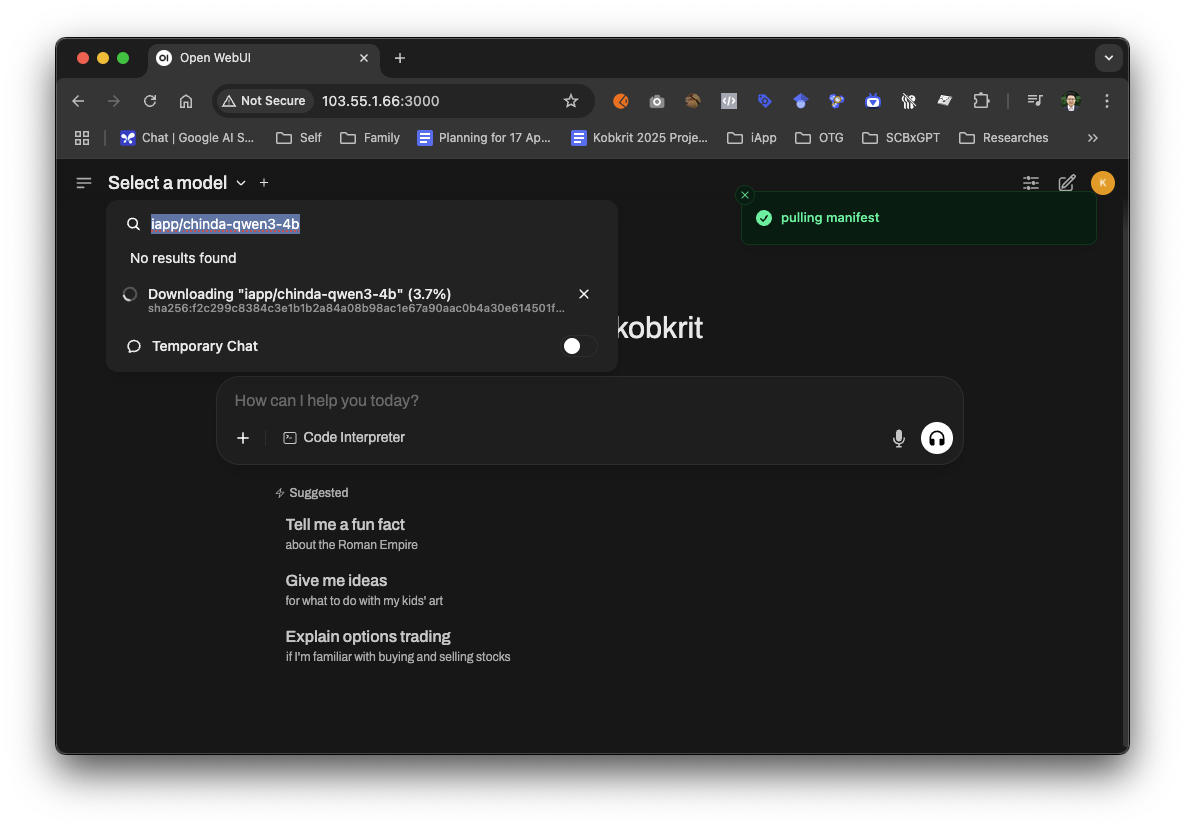

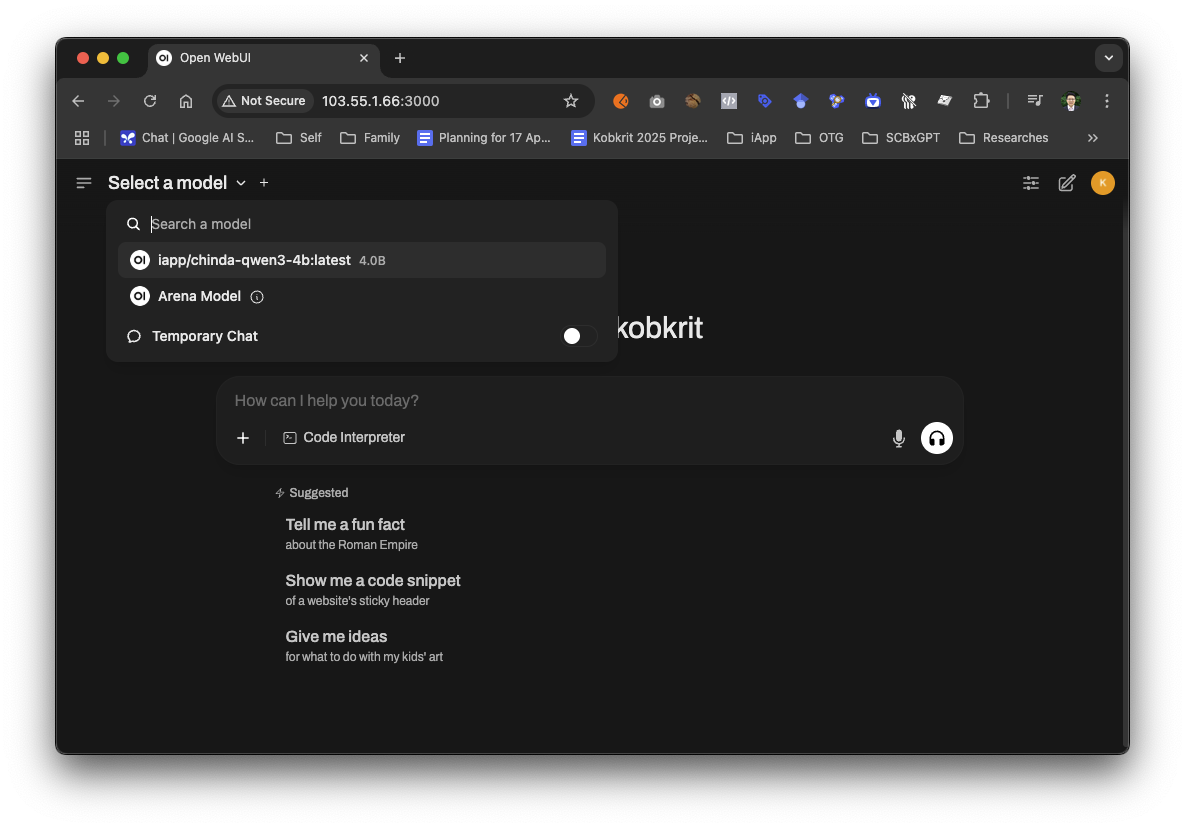

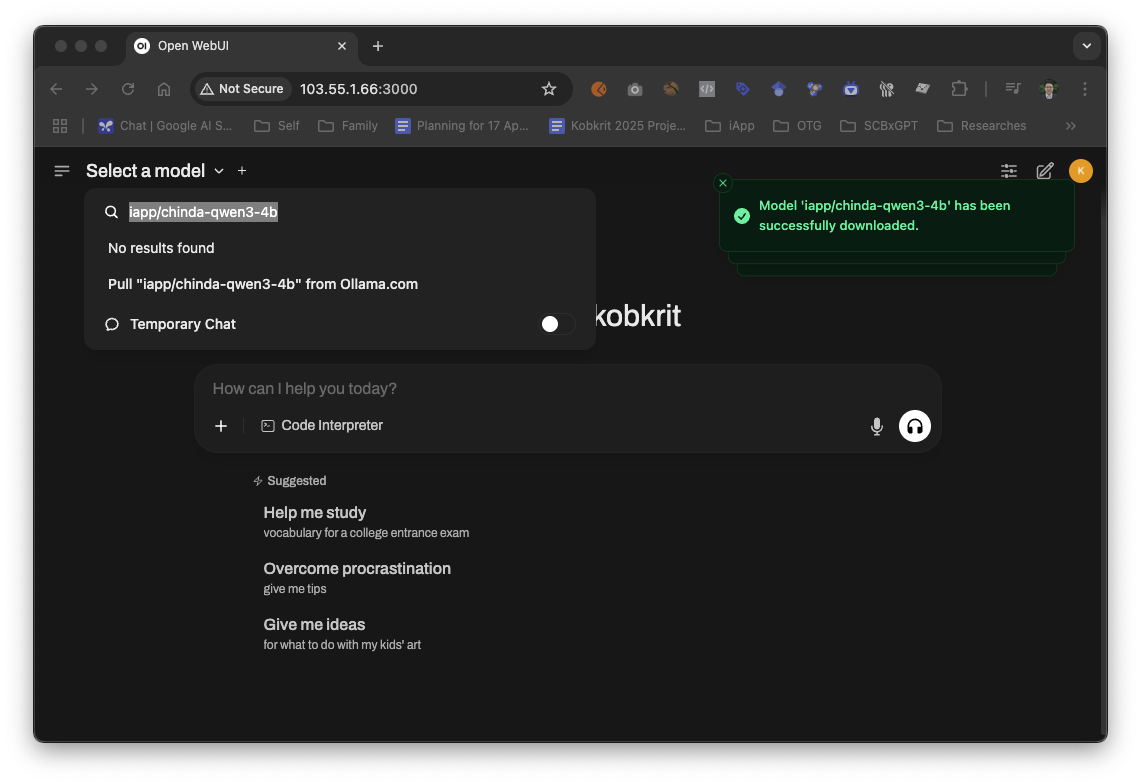

使用 OpenWebUI 界面 (推荐)

OpenWebUI 运行后,您可以直接通过 Web 界面下载 Chinda LLM 4B 模型:

- 打开浏览器并前往

http://localhost:3000 - 完成初始设置(创建账户)

- 在模型搜索框中键入

iapp/chinda-qwen3-4b来搜索模型

- 点击 从 Ollama.com 拉取 "iapp/chinda-qwen3-4b"

- 等待下载完成(大约 2.5GB)

- 模型下载完成后,您会收到成功通知

使用 Docker Exec (替代方案)

您也可以使用 Docker exec 下载模型:

# 下载 Chinda LLM 4B 模型

docker exec -it open-webui ollama pull iapp/chinda-qwen3-4b

# 验证模型是否已下载

docker exec -it open-webui ollama list

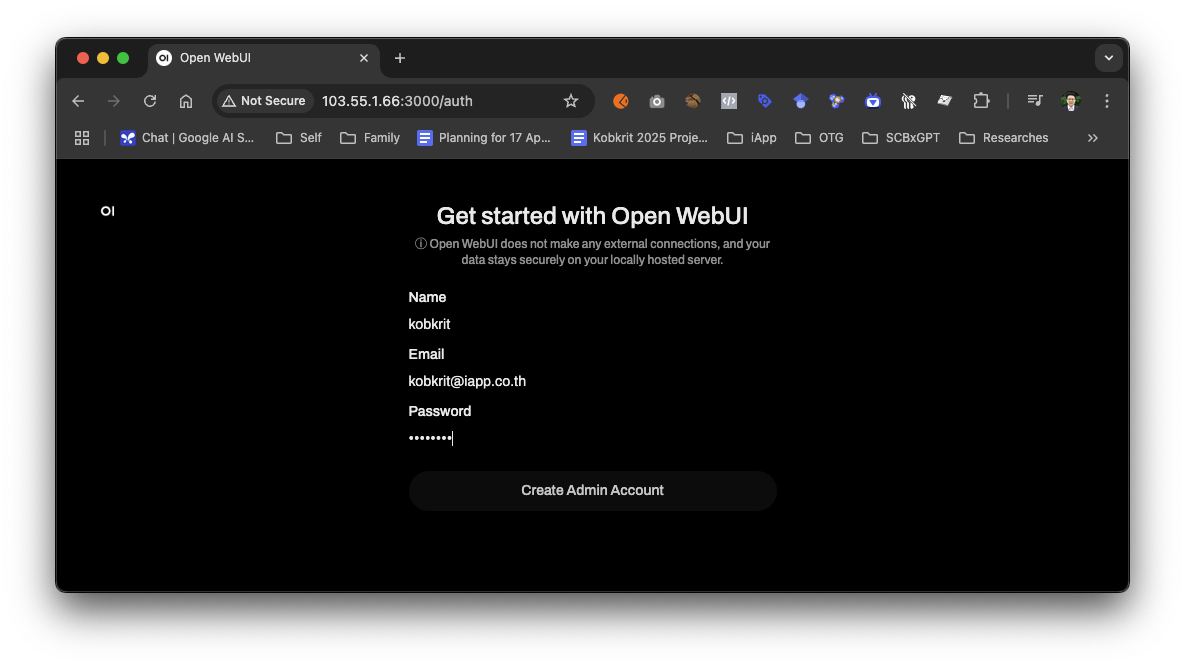

🔍 第 4 步:初始设置

创建您的账户

- 首次访问时,您会看到一个 注册 表单

- 输入您偏好的电子邮件和密码

- 点击 创建账户

- 您将自动登录

注意: 这是一个仅用于您电脑的本地账户 - 没有任何数据发送到外部服务器。

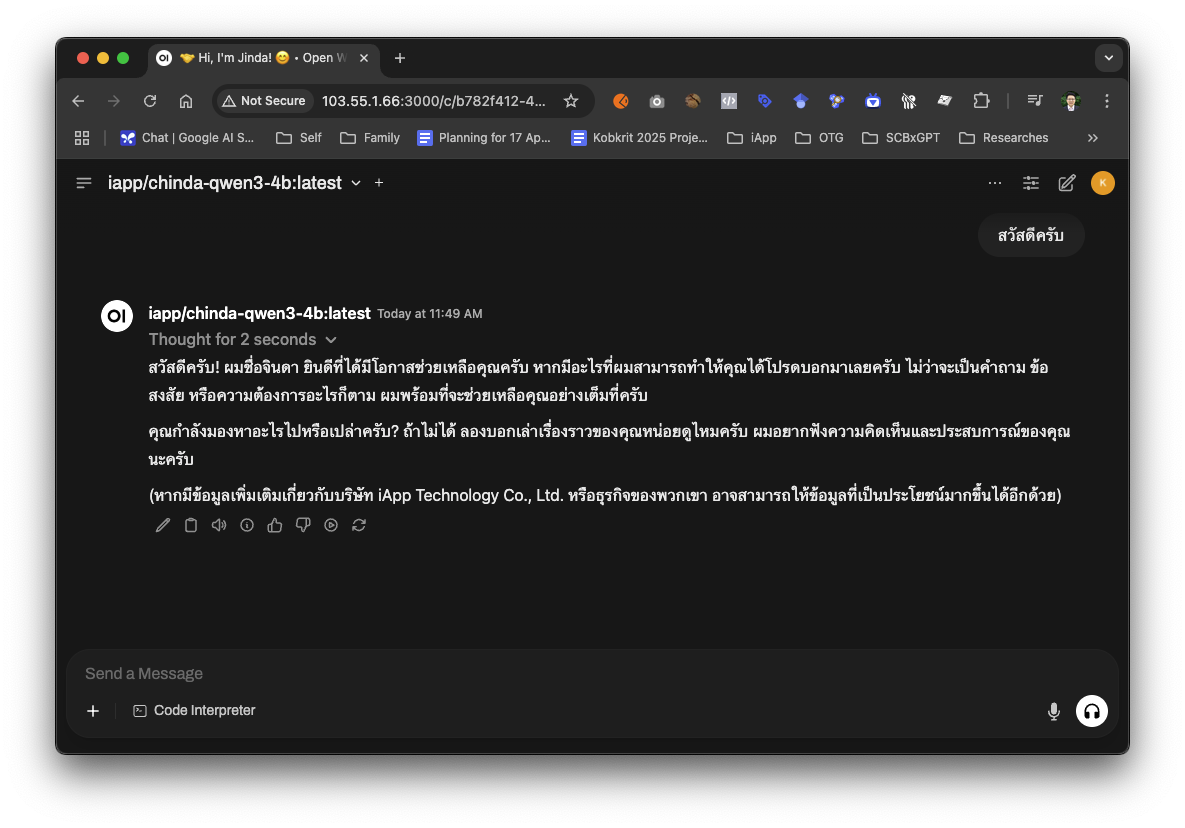

⚙️ 第 5 步:使用 Chinda LLM 4B

选择模型

- 在聊天界面中,查看顶部的 模型 下拉菜单

- 从列表中选择

chinda-qwen3-4b:latest - 如果您没有看到它,请确保您已按照上述步骤下载了模型

开始您的第一次对话

- 在聊天框中输入您的泰语消息

- 按 Enter 键或点击发送按钮

- Chinda LLM 将用泰语回复

对话示例:

如上面的截图所示,Chinda LLM 自然地用泰语回复,并介绍自己是由 iApp Technology Co., Ltd. 开发的 AI 助手。该模型展示了它理解上下文并在泰语中提供深思熟虑的响应的能力。

数学问题:

您:ช่วยแก้สมการ 3x + 7 = 22 ให้หน่อย

Chinda:ผมจะช่วยแก้สมการ 3x + 7 = 22 ให้คุณครับ

ขั้นตอนการแก้:

1) 3x + 7 = 22

2) 3x = 22 - 7

3) 3x = 15

4) x = 15 ÷ 3

5) x = 5

ดังนั้น x = 5 ครับ

文档写作:

您:ช่วยเขียนอีเมลขอบคุณลูกค้าให้หน่อย

Chinda:ผมจะช่วยเขียนอีเมลขอบคุณลูกค้าให้คุณครับ

เรื่อง: ขอบพระคุณสำหรับการใช้บริการ

เรียน คุณลูกค้าที่เคารพ,

ทางบริษัทฯ ขอขอบพระคุณอย่างสูงสำหรับการให้ความไว้วางใจและใช้บริการของเรา...

🎨 第 6 步:高级功能

对话管理

创建新聊天:

- 点击 + 按钮开始新的对话

- 每个对话都会单独保存

- 您可以随时在对话之间切换

重命名对话:

- 点击对话标题

- 输入新名称以整理您的聊天记录

导出对话:

- 点击对话设置(三个点)

- 选择 导出 以 JSON 或 Markdown 格式保存

自定义模型设置

访问模型设置:

- 点击模型名称旁边的 设置 图标

- 调整参数,例如:

- 温度 (0.1-1.0):控制创造力

- Top P (0.1-1.0):控制响应多样性

- Top K (1-100):限制词汇选择

- Max Tokens:最大响应长度

Chinda LLM 推荐设置:

- 温度: 0.7 (平衡的创造力)

- Top P: 0.9 (良好的多样性)

- Top K: 40 (专注的响应)

系统提示

您可以设置自定义系统提示来修改 Chinda 的行为:

系统提示示例:

用于专业写作:

คุณเป็นผู้ช่วยเขียนเอกสารมืออาชีพ ตอบด้วยภาษาไทยที่เป็นทางการและสุภาพ

用于教育内容:

คุณเป็นครูสอนภาษาไทย อธิบายให้เข้าใจง่าย ใช้ตัวอย่างประกอบ

用于创意写作:

คุณเป็นนักเขียนที่มีจินตนาการสูง สร้างเนื้อหาที่น่าสนใจและสร้างสรรค์

📊 第 7 步:模型管理

查看可用模型

- 前往 设置 → 模型

- 查看所有已下载的模型

- 检查模型大小和信息

下载新模型

使用容器:

# 使用 docker exec 下载新模型

docker exec -it open-webui ollama pull <model-name>

或使用 OpenWebUI 界面:设置 → 模型 → 从 Ollama.com 拉取模型

删除模型

# 使用 docker exec 删除模型

docker exec -it open-webui ollama rm <model-name>

🔧 第 8 步:故障排除

常见问题及解决方案

问题:找不到 Chinda 模型

症状: 模型未出现在下拉列表中 解决方案:

- 检查容器是否正在运行:

docker ps - 验证模型是否已下载:

docker exec -it open-webui ollama list - 如果需要,下载模型:

docker exec -it open-webui ollama pull iapp/chinda-qwen3-4b - 刷新 OpenWebUI 页面

问题:“连接错误”或容器无法启动

症状: 无法访问 OpenWebUI 或容器启动失败 解决方案:

- 检查 Docker 是否正在运行:

docker version - 验证容器状态:

docker ps -a - 检查容器日志:

docker logs open-webui - 重启容器:

docker restart open-webui

问题:响应缓慢

解决方案:

- 关闭不必要的应用程序

- 在模型设置中减少 Max Tokens

- 降低温度和 top_k 值

- 确保有足够的 RAM(推荐 8GB+)

问题:GPU 未正常工作

症状: 尽管有 GPU 但性能缓慢 解决方案:

- 验证 NVIDIA 驱动程序:

nvidia-smi - 检查 NVIDIA Container Toolkit:

docker run --rm --gpus all nvidia/cuda:11.0-base nvidia-smi - 使用 GPU 支持重新启动容器:

# 停止现有容器

docker stop open-webui

docker rm open-webui

# 使用 GPU 支持运行

docker run -d -p 3000:8080 --gpus all -v ollama:/root/.ollama -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:ollama

性能优化

- 使用 SSD 存储 以获得更好的模型加载速度

- 分配足够的 RAM(最少 8GB)

- 关闭后台应用程序

- 如果内存有限,使用较低的精度设置

🎯 适用场景

✅ Chinda LLM 4B 在 OpenWebUI 中表现出色

- 交互式对话 - 具有对话历史的自然聊天体验

- 文档起草 - 轻松编辑文档并进行迭代

- 教育内容 - 通过保存的对话参考进行学习

- 创意写作 - 通过多次修订来开发故事和内容

- 编程帮助 - 代码生成,支持语法高亮

- 语言翻译 - 快速泰语-英语翻译

- 研究助手 - 在多个聊天中整理信息

🌟 OpenWebUI 的特定优势

- 精美界面 - 干净、现代的设计,类似于 ChatGPT

- 对话历史 - 所有聊天都会自动保存

- 多模型支持 - 轻松切换不同的模型

- 导出选项 - 以各种格式保存对话

- 可自定义设置 - 为不同的用例微调模型行为

- 无需互联网 - 通过本地处理实现完全隐私

❌ 需要注意的限制

不要在没有上下文的情况下询问事实,例如:

- 最新新闻事件(模型训练截止日期适用)

- 没有来源的具体统计数据

- 实时信息

- 关于特定人物或当前事件的信息

由于 Chinda LLM 4B 是一个 4B 参数模型,当被问及具体事实时,它可能会生成错误的信息(幻觉)。

🚀 模型规格

- 大小: 2.5GB(量化)

- 上下文窗口: 40K 令牌

- 架构: 基于 Qwen3-4B,针对泰语进行了优化

- 性能: 在消费级硬件上进行快速推理

- 内存要求: 最低 4GB RAM,推荐 8GB+

- 界面: 现代 Web 聊天界面

🔮 未来展望

iApp Technology 团队正在开发一个更大、更强的模型,该模型将能够更准确地回答事实性问题。预计很快发布,并将与 OpenWebUI 兼容。

📚 更多资源

快速设置命令

无 GPU:

# 1. 运行集成 Ollama 的 OpenWebUI

docker run -d -p 3000:8080 -v ollama:/root/.ollama -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:ollama

# 2. 在浏览器中打开 http://localhost:3000

# 3. 下载 Chinda LLM 模型(通过 Web 界面或命令)

docker exec -it open-webui ollama pull iapp/chinda-qwen3-4b

有 GPU:

# 1. 运行带 GPU 支持的 OpenWebUI

docker run -d -p 3000:8080 --gpus all -v ollama:/root/.ollama -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:ollama

# 2. 在浏览器中打开 http://localhost:3000

# 3. 下载 Chinda LLM 模型

docker exec -it open-webui ollama pull iapp/chinda-qwen3-4b

有用的键盘快捷键

- Ctrl/Cmd + Enter: 发送消息

- Ctrl/Cmd + N: 新对话

- Ctrl/Cmd + K: 聚焦搜索

- Esc: 取消当前生成

Docker 管理命令

# 查看容器状态

docker ps

# 停止 OpenWebUI

docker stop open-webui

# 启动 OpenWebUI

docker start open-webui

# 重启 OpenWebUI

docker restart open-webui

# 查看日志

docker logs open-webui

# 访问容器 shell

docker exec -it open-webui bash

# 检查容器内的 Ollama 模型

docker exec -it open-webui ollama list

# 更新 OpenWebUI

docker pull ghcr.io/open-webui/open-webui:ollama

docker stop open-webui

docker rm open-webui

# 然后再次运行安装命令

# 备份卷(重要!)

docker run --rm -v ollama:/source -v $(pwd):/backup alpine tar czf /backup/ollama-backup.tar.gz -C /source .

docker run --rm -v open-webui:/source -v $(pwd):/backup alpine tar czf /backup/openwebui-backup.tar.gz -C /source .

链接和资源

- 🌐 演示: https://chindax.iapp.co.th (选择 ChindaLLM 4b)

- 📦 模型下载: https://huggingface.co/iapp/chinda-qwen3-4b

- 🐋 Ollama: https://ollama.com/iapp/chinda-qwen3-4b

- 🌐 OpenWebUI: https://github.com/open-webui/open-webui

- 🏠 主页: https://iapp.co.th/openmodels/chinda-opensource-llm

- 📄 许可证: Apache 2.0(可用于商业和个人用途)

🎉 总结

Chinda LLM 4B 搭配 OpenWebUI,完美结合了强大的泰语 AI 能力和美观、用户友好的界面。此设置为您提供:

主要优势:

- 🎨 美观界面 - 类似于 ChatGPT 的现代 Web UI

- 💾 对话历史 - 永不丢失您重要的聊天记录

- 🔒 完全隐私 - 所有内容都在本地您的机器上运行

- 🚀 易于使用 - 无需命令行知识

- 🎛️ 可自定义 - 针对不同用例调整设置

- 📱 跨平台 - 在任何有 Web 浏览器的设备上均可运行

适用于:

- 需要组织对话历史的学生和研究人员

- 希望迭代想法的作家和内容创作者

- 需要文档起草帮助的商务专业人士

- 想要用户友好界面的 AI 集成的开发者

- 任何更喜欢 Web 界面而非命令行工具的任何人

立即开始使用 OpenWebUI 的 Chinda LLM 4B,并通过现代 Web 界面的便利性体验泰语 AI 的未来!

由 iApp Technology Team 致爱心开发 - 为泰语 AI 发展而生