DeepSeek-V3.2 新

由 DeepSeek AI 提供支持

由 DeepSeek AI 提供支持按 Token 计价

输入:0.01 IC / 1K tokens (约 10 泰铢/1M, 约 $0.30/1M)输出:0.02 IC / 1K tokens (约 20 泰铢/1M, 约 $0.60/1M)

欢迎使用 iApp DeepSeek-V3.2 API,由最新的 DeepSeek-V3.2 模型提供支持。此 API 提供对最先进的开源大语言模型之一的访问,具有卓越的推理能力、与 GPT-4 和 Claude Sonnet 相当的性能,以及完全兼容 OpenAI 的接口。

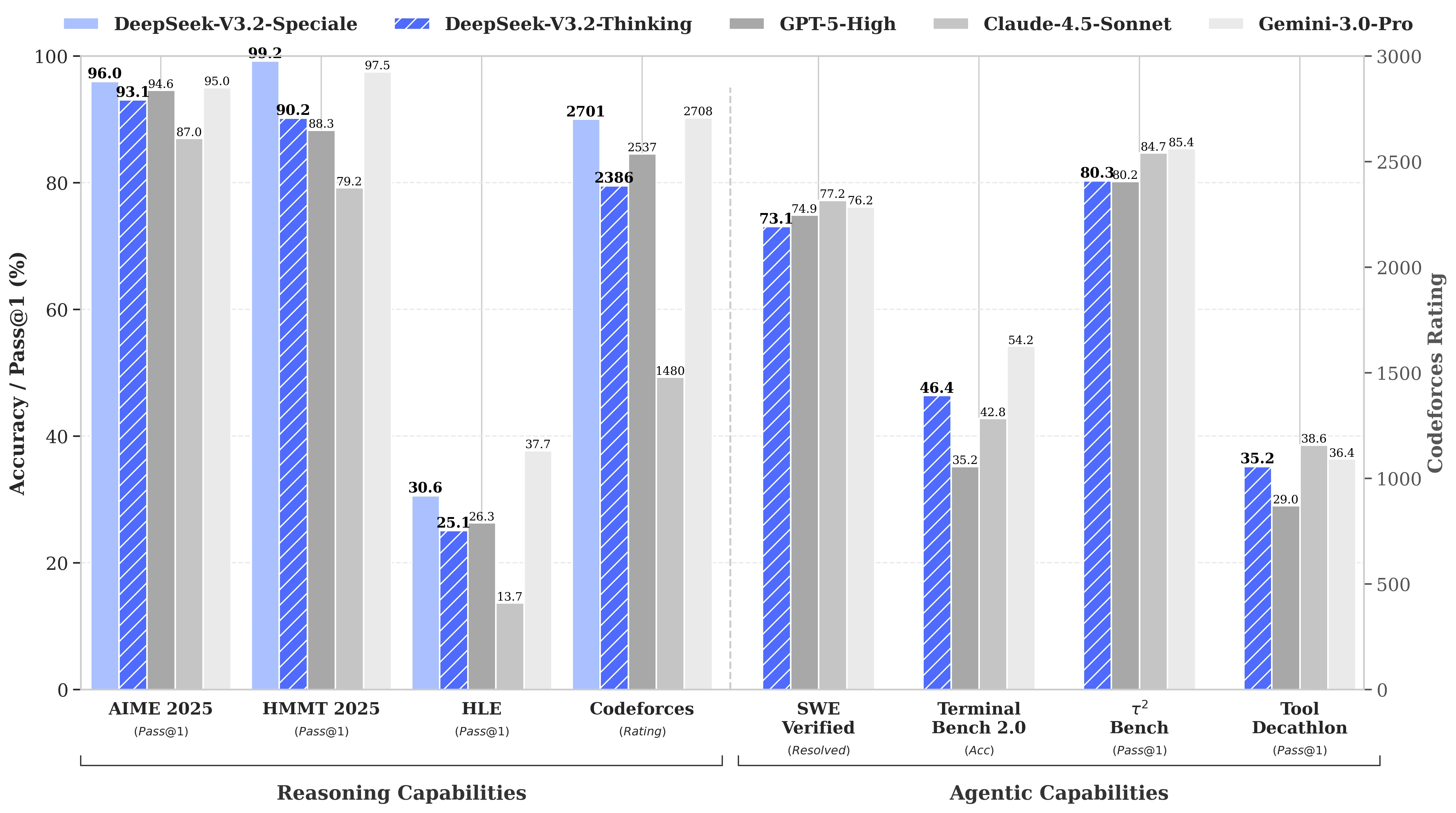

基准测试结果

DeepSeek-V3.2 在多个基准测试中表现出色:

核心性能亮点

- 685B 参数:具有最先进能力的大规模模型

- 128K 上下文长度:支持长文档的扩展上下文窗口

- 推理模式:使用

deepseek-reasoner模型内置链式思维推理 - 兼容 OpenAI:可直接替代 OpenAI API

- 金牌级表现:在国际数学奥林匹克(IMO)和国际信息学奥林匹克(IOI)中达到金牌水平

试用演示

DeepSeek-V3.2 聊天

Start a conversation with the AI assistant

Type your message below and press Enter or click Send概述

DeepSeek-V3.2 代表了一种先进的以推理为中心的模型,旨在将高计算效率与卓越的推理和代理性能相协调。它引入了三项核心创新:

- DeepSeek Sparse Attention (DSA):一种高效的注意力机制,在保持扩展上下文性能的同时降低计算复杂度

- 可扩展强化学习框架:用于增强推理能力的后训练方法

- 代理任务合成管道:将推理能力集成到工具使用场景中

主要功能

- 高级推理:内置思考模式,提供明确的推理过程

- 兼容 OpenAI:遵循 OpenAI API 格式,便于集成

- 流式支持:实时 token 流式传输,适用于响应式应用

- 128K 上下文:支持最多 128,000 tokens 的上下文长度

- 泰语和英语:支持泰语和英语

- 性价比高:企业级 AI 的竞争性定价

快速开始

-

前提条件

- iApp Technology 的 API key

- 互联网连接

-

快速入门

- 简单的 REST API 接口

- 兼容 OpenAI 格式

- 支持流式和非流式

-

速率限制

- 每秒 5 个请求

- 每分钟 200 个请求

如何获取 API Key?

请访问 API Key 管理 页面查看现有的 API key 或申请新的。

API 端点

| 端点 | 方法 | 描述 | 费用 |

|---|---|---|---|

/v3/llm/deepseek-3p2/chat/completions | POST | Chat completions(流式和非流式) | 0.01 IC/1K 输入 + 0.02 IC/1K 输出 |

可用模型

| 模型 | 描述 |

|---|---|

deepseek-reasoner | �带有明确推理的思考模式(推荐) |

deepseek-chat | 无思考模式,响应更快 |

代码示例

cURL - 非流式

curl -X POST 'https://api.iapp.co.th/v3/llm/deepseek-3p2/chat/completions' \

-H 'apikey: YOUR_API_KEY' \

-H 'Content-Type: application/json' \

-d '{

"model": "deepseek-reasoner",

"messages": [

{"role": "user", "content": "你好,你能帮我什么?"}

],

"max_tokens": 4096,

"temperature": 0.7,

"top_p": 0.9

}'

cURL - 流式

curl -X POST 'https://api.iapp.co.th/v3/llm/deepseek-3p2/chat/completions' \

-H 'apikey: YOUR_API_KEY' \

-H 'Content-Type: application/json' \

-d '{

"model": "deepseek-reasoner",

"messages": [

{"role": "user", "content": "你好,��你能帮我什么?"}

],

"max_tokens": 4096,

"temperature": 0.7,

"top_p": 0.9,

"stream": true

}'

响应示例(带推理的非流式)

使用 deepseek-reasoner 时,响应包含 reasoning_content 字段,显示模型的思考过程:

{

"id": "233c1fa8-e6ea-4b4f-86b5-2bbccb39fd9e",

"object": "chat.completion",

"created": 1764635256,

"model": "deepseek-reasoner",

"choices": [

{

"index": 0,

"message": {

"role": "assistant",

"content": "你好!我可以帮助你很多事情。",

"reasoning_content": "用户用"你好"问候我。这是一个基本的问候,我应该友好地回应并提供帮助..."

},

"logprobs": null,

"finish_reason": "stop"

}

],

"usage": {

"prompt_tokens": 12,

"completion_tokens": 109,

"total_tokens": 121

}

}

Python

import requests

import json

url = "https://api.iapp.co.th/v3/llm/deepseek-3p2/chat/completions"

payload = {

"model": "deepseek-reasoner",

"messages": [

{"role": "user", "content": "你好,你能帮我什么?"}

],

"max_tokens": 4096,

"temperature": 0.7,

"top_p": 0.9

}

headers = {

'apikey': 'YOUR_API_KEY',

'Content-Type': 'application/json'

}

response = requests.post(url, headers=headers, json=payload)

print(response.json())

JavaScript / Node.js

const axios = require('axios');

const url = 'https://api.iapp.co.th/v3/llm/deepseek-3p2/chat/completions';

const payload = {

model: 'deepseek-reasoner',

messages: [

{ role: 'user', content: '你好,你能帮我什么?' }

],

max_tokens: 4096,

temperature: 0.7,

top_p: 0.9

};

const config = {

headers: {

'apikey': 'YOUR_API_KEY',

'Content-Type': 'application/json'

}

};

axios.post(url, payload, config)

.then(response => {

console.log(response.data.choices[0].message.content);

})

.catch(error => {

console.error(error);

});

API 参考

请求头

| 参数 | 类型 | 必需 | 描述 |

|---|---|---|---|

| apikey | String | 是 | 您的 API key |

| Content-Type | String | 是 | application/json |

请求体参数

| 参数 | 类型 | 必需 | 描述 |

|---|---|---|---|

| model | String | 是 | 模型名称:deepseek-reasoner 或 deepseek-chat |

| messages | Array | 是 | 包含 role 和 content 的消息对象数组 |

| max_tokens | Integer | 否 | 生成的最大 tokens(默认:4096,最大:128000) |

| stream | Boolean | 否 | 启用流式响应(默认:false) |

| temperature | Float | 否 | 采样温度 0-2(默认:0.7) |

| top_p | Float | 否 | 核采样(默认:0.9) |

消息对象

| 字段 | 类型 | 描述 |

|---|---|---|

| role | String | system、user 或 assistant |

| content | String | 消息内容 |

响应字段

| 字段 | 类型 | 描述 |

|---|---|---|

| content | String | 生成的响应 |

| reasoning_content | String | (仅限 deepseek-reasoner)推理过程 |

推荐的温度设置

| 用例 | 温度 |

|---|---|

| 编程 / 数学 | 0.0 |

| 数据分析 | 1.0 |

| 一般对话 | 1.3 |

| 翻译 | 1.3 |

| 创意写作 | 1.5 |

模型信息

| 属性 | 值 |

|---|---|

| 模型名称 | deepseek-reasoner / deepseek-chat |

| 基础模型 | DeepSeek-V3.2 |

| 参数 | 685B |

| 上下文长度 | 128,000 tokens |

| 支持语言 | 泰语、英语、中文等 |

| 许可证 | MIT |

应用场景

- 高级推理:复杂问题解决、数学证明、逻辑推导

- 编程辅助:代码生成、调试、代码解释

- 内容生成:多语言文章、报告、创意写作

- 翻译:泰语、英语和其他语言之间的高质量翻译

- 问答系统:具有推理能力的智能问答

- 数据分析:数据解读和洞察生成

定价

| AI API 服务名称 | 端点 | IC 费用 | 本地部署 |

|---|---|---|---|

| DeepSeek-V3.2 [v3.2] | /v3/llm/deepseek-3p2/chat/completions | 输入:0.01 IC / 1K tokens(约 10 泰铢/1M,约 $0.30/1M) | 联系我们 |

支持

如需支持和咨询:

- Discord:加入我们的社区

- 邮箱:support@iapp.co.th

- 文档:完整 API 文档