推出支持 OpenAI Harmony 格式的 GPT-OSS-120B 和 GPT-OSS-20B

OpenAI 正通过发布两款强大的新模型:GPT-OSS-120B 和 GPT-OSS-20B,重返开源 AI 领域。这些开放权重推理模型可根据 Apache 2.0 许可证使用,在推理能力方面取得了重大进展,并原生支持 OpenAI Harmony 响应格式。

什么是 GPT-OSS 模型?

GPT-OSS 模型代表了 OpenAI 在开源开发方面的回归,采用先进的专家混合(MoE)架构,旨在提供企业级的推理性能,同时保持效率。这些模型于 2025 年 8 月根据 Apache 2.0 许可证发布,为从企业服务器到消费设备的各种部署场景提供了不同的性能-效率权衡。

GPT-OSS-120B:企业级性能

该 1170 亿参数模型(总计 1168 亿,每个 token 激活参数 51 亿)提供:

- 高级推理:在竞赛编码(Codeforces)和问题解决(MMLU)方面,性能优于 OpenAI o3-mini,并与 o4-mini 相当

- MoE 架构:专家混合设计,具有交替的密集注意力和局部带状稀疏注意力模式

- 长上下文窗口:原生支持高达 128k 的上下文长度,并带有旋转位置嵌入(RoPE)

- 企业集成:针对推理、代理任务和开发者用例进行了优化

- MXFP4 量化:MoE 权重被量化为 MXFP4 格式,可在单个 80GB GPU 上部��署

GPT-OSS-20B:高效便捷

该 210 亿参数模型(总计 209 亿,每个 token 激活参数 36 亿)侧重于:

- 消费级硬件:仅需 16GB 内存即可在笔记本电脑和 Apple Silicon 设备上运行

- 竞争力:尽管尺寸较小,但性能与 o3-mini 相当或更优,在数学方面表现尤为出色

- 边缘部署:非常适合设备端应用和消费级硬件

- MXFP4 效率:由于量化的 MoE 权重,仅需 16GB 内存

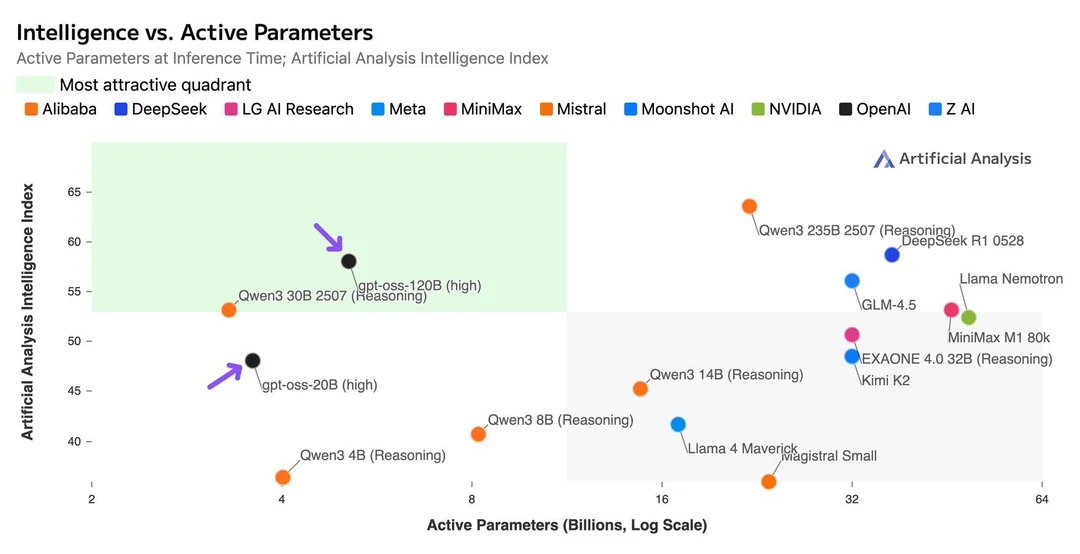

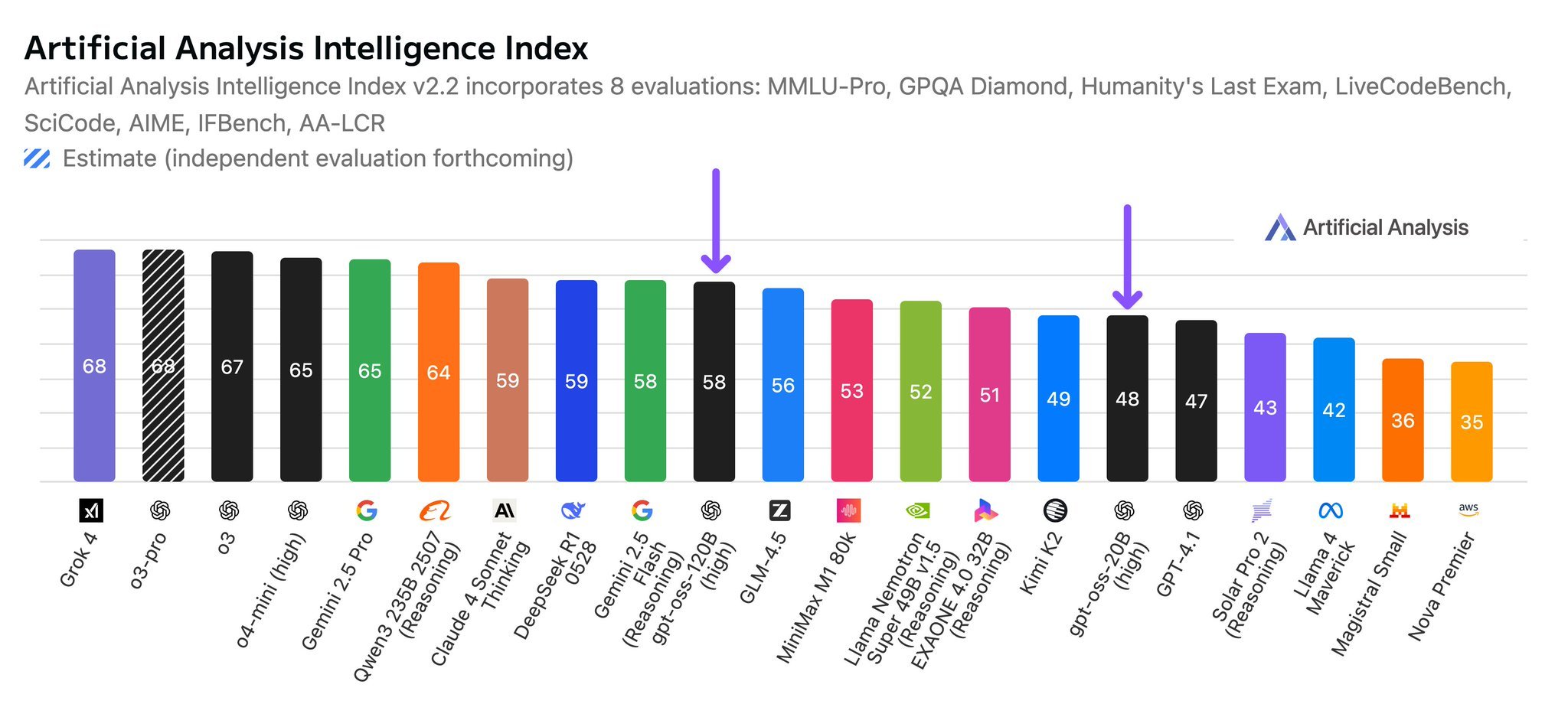

性能基准

两款 GPT-OSS 模型在各种评估指标上均表现出卓越的性能,在开源 AI 领域确立了它们极具竞争力的地位。

基准测试结果

基准测试结果显示:

- GPT-OSS-120B 在竞赛编码和通用问题解决方面,性能优于 OpenAI o3-mini,并与 o4-mini 相当

- GPT-OSS-20B 尽管尺寸较小,但在性能上与 o3-mini 相当或更优,尤其在数学方面表现出色

- 两款模型在推理、编码和知识任务等各种评估类别中均表现强劲

- 模型在保持竞争力的同时,提供了开源可访问性和本地部署的优势

这些结果使 GPT-OSS 模型成为专有解决方案的强大替代方案,特别是对于需要高性能 AI 功能并完全控制其部署环境的组织而言。

OpenAI Harmony 格式:结构化对话

两款模型均原生支持 OpenAI Harmony 响应格式,带来多项关键优势:

多通道通信

Harmony 格式将响应组织成三个独立的通道:

- 最终通道:面向用户的响应,提供清晰、可操作的信息

- 分析通道:内部推理和思维链过程

- 评论通道:函数调用、工具使用和实现细节

基于角色的层级结构

五个定义的角色创建了清晰的信息层级:

- 系统:最高优先级的配置和约束

- 开发者:实现指南和技术规范

- ��用户:最终用户请求和需求

- 助手:AI 生成的响应和推理

- 工具:外部函数调用和数据检索

增强的推理能力

该格式支持多种推理努力级别:

- 低强度:针对简单查询的快速响应

- 中强度:针对标准任务的均衡推理

- 高强度:针对复杂问题解决的深度分析

实际应用

企业文档处理

<|channel|>analysis<|message|>

用户请求处理季度财务报告。需要分析文档结构,识别关键财务指标,并与历史数据进行交叉引用以获取背景和趋势。

<|end|>

<|start|>assistant<|channel|>final<|message|>

第三季度财务报告显示,AI 服务部门的收入增长了 15%,利润率有所提高。

<|return|>

多语言客户支持

这些模型在跨语言提供结构化支持方面表现出色,在适应文化背景的同时保持一致性。

工具调用和函数集成

Harmony 格式在结构化工具调用和函数集成方面表现出色:

<|channel|>analysis<|message|>

用户想要东京的天气信息。需要调用天气 API,解析响应,并格式化以供用户使用。

<|end|>

<|start|>assistant<|channel|>commentary<|message|>

调用 weather_api(location="Tokyo", units="celsius")

<|end|>

<|start|>tool<|channel|>commentary<|message|>

{"temperature": 24, "condition": "sunny", "humidity": 65, "wind_speed": 12}

<|end|>

<|start|>assistant<|channel|>final<|message|>

东京目前天气晴朗,气温 24°C,湿度 65%,风速 12 公里/小时。

<|return|>

研究与开发

分析通道为模型推理过程提供了透明度,这对于研究应用和模型可解释性至关重要。

实现注意事项

基础设施要求

- GPT-OSS-120B:得益于 MoE 权重的 MXFP4 量化,可在单个 80GB GPU(H100、A100 或 AMD MI300X)上运行

- GPT-OSS-20B:仅需 16GB 内存,适用于消费级硬件、笔记本电脑和移动设备

集成策略

两款模型均支持标准推理 API,并通过 Harmony 格式集成提供增强功能。关键技术特性包括:

- Transformer 架构:利用分组多查询注意力(组大小为 8)以提高内存效率

- MoE 设计:每个模型使用专家混合(Mixture-of-Experts)来减少每个 token 的激活参数

- 注意力模式:交替的密集注意力和局部带状稀疏注意力,类似于 GPT-3

- 位置编码:旋转位置嵌入(RoPE)以提高序列理解能力

组织可以:

- 从使用标准格式的现有实现开始

- 逐步采用 Harmony 功能以增强功能

- 利用分析通道进行调试和优化

未来影响

强大的开源模型与结构化对话格式的结合,标志着朝着更透明、更可控的 AI 系统迈出了重要一步。Harmony 格式的基于角色的方法和多通道通信实现了:

- 改进的调试:推理和输出的清晰分离

- 更好的监控:用于系统分析的结构化日志

- 增强的控制:对 AI 行为进行精细管理

- 透明度:关键应用的可见推理过程

入门指南

有兴趣实施支持 Harmony 格式的 GPT-OSS 模型的组织应考虑:

- 评估:评估计算要求和用例

- 试点测试:从 GPT-OSS-20B 开始进行初步探索

- 集成规划:设计系统以利用多通道通信

- 培训:为团队准备 Harmony 格式的实施

GPT-OSS-120B 和 GPT-OSS-20B 在 Apache 2.0 许可证下发布,并支持 OpenAI Harmony 格式,标志着 OpenAI 在开源 AI 领域的重要回归。这些模型为组织提供了强大的工具,用于构建透明、可控且有效的推理解决方案,这些解决方案可以运行在从企业服务器到消费笔记本电脑的各种设备上。

联系我们 了解 艾艾普科技 如何帮助您组织的 AI 基础架构实施这些先进模型。